Scrive un post con l’intelligenza artificiale: inganna 26 mila persone e arriva in cima ad Hacker News

Liam Porr è uno studente universitario che ha pensato bene di utilizzare GPT-3, lo strumento di intelligenza artificiale adibito alla generazione di linguaggio naturale, per realizzare un post artificiale che è arrivato al primo posto su Hacker News. Lo scopo di Porr era quello di dimostrare che il materiale prodotto da GPT-3 potesse passare come scritto da un essere umano. “In realtà è stato semplicissimo, il che è la parte spaventosa” è stato il commento dello studente.

GPT-3 è l’ultima versione di una serie di strumenti di completamento automatico progettati da OpenAI e in sviluppo ormai da diversi anni. Nella sua forma più elementare GPT-3 completa automaticamente il testo sulla base dei suggerimenti ricevuti da un essere umano.

E’ un sistema basato su deep learning, il cui principio di funzionamento è quello di ricercare modelli e occorrenze in grandi moli di dati. Nello specifico GPT-3 è stato formato su un enorme corpus di testo per il quale elabora una serie di regolarità statistiche. GPT-3 non prevede alcun intervento umano nella fase di addestramento e cerca e trova schemi e ricorrenze senza alcuna guida, schemi che son poi utilizzati per completare i testi. Per esempio inserendo la parola “pioggia”, il sistema sa che è più probabile che venga seguita da parole come “ombrello” o “stivali” invece che “arrosto” o “portafoglio”.

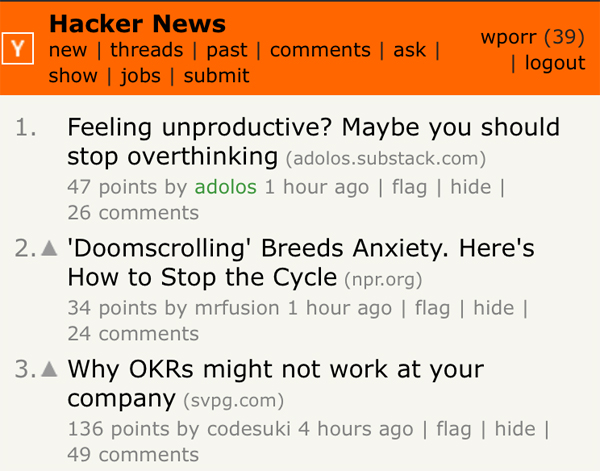

Il post di Porr, titolato “Feeling unproductive? Maybe you should stop overthinking”, si trova a questa pagina, e ve ne proponiamo un piccolo estratto di seguito (ovviamente in lingua originale):

Anyone can get into the habit of engaging in creative thinking. For example, if you’re good at math then try writing a poem about a number or drawing a picture of a mathematical equation. If you’re good at writing poems then try drawing a picture to go along with it. If you’re good at drawing pictures then try writing a story about it.

GPT-3 è stato reso disponibile da OpenAI in forma di beta privata al pubblico dei ricercatori. Porr, studente di informatica presso l’Università della California, Berkeley, ha collaborato con un altro studente che già aveva accesso alle API di GPT-3. Tutto ciò che Porr ha fatto è stato realizzare uno script per dare in pasto a GPT-3 un titolo e una breve introduzione. Ha generato poi alcune versioni del post e ne ha scelta una da pubblicare, con pochissime modifiche. Praticamente quasi solo un copia-incolla.

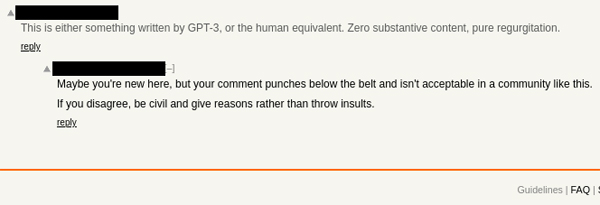

Nel giro di poche ore il post è diventato virale, con oltre 26 mila visitatori e scalando le classifiche di Hacker News. Un solo utente ha chiesto esplicitamente se il post fosse stato generato dall’intelligenza artificiale, mentre alcuni altri hanno solo ipotizzato la possibilità. Porr però ha sottolineato che la community ha declassato questi commenti.

“Mi sono molto divertito con questo esperimento. Alcune persone potrebbero arrabbiarsi con me per averle ingannate, ma pazienza. Il punto di rilasciare questo in beta privata è che in questo modo la community può mostrare nuovi casi d’uso per OpenAI che dovrebbero incoraggiare o tenere d’occhio” ha scritto Porr sul proprio blog personale.

FONTE

Un articolo scritto da un’intelligenza artificiale ha battuto quelli tradizionali

È successo con un blog di uno studente universitario statunitense: usando una versione ancora in fase di sviluppo di un software di scrittura automatica, è riuscito a scalare tutte le classifiche e a diventare virale. Sono servite solo due ore di lavoro

Il suo nome è Liam Porr, anche se i suoi articoli sono firmati con lo pseudonimo Adolos. È un giovane studente di informatica all’università di Berkeley, in California, e come hobby ha deciso nelle scorse settimane di aprire un blog sui generis: anziché riempirlo di contenuti originali scritti di suo pugno, li fa scrivere in modo automatico da un’intelligenza artificiale, a cui dà solo qualche imbeccata.

Un’iniziativa che non avrebbe fatto notizia, se non fosse che Porr ha utilizzato un tool tutt’ora in fase beta di sviluppo e non ancora reso pubblico (è riuscito ad avere accesso al tool attraverso “una collaborazione” con un dottorando che fa parte del team di sviluppo), e soprattutto che gli articoli fake scritti in questo modo sono diventati virali e hanno scalato molte classifiche di visualizzazione, guadagnando temporaneamente il primo posto su Hacker News. Nello specifico, il tool di deep learning impiegato si chiama Gpt-3, che sta per Generative Pretrained Transformer, ed è di proprietà della OpenAi di San Francisco.

Una scalata “fin troppo facile”

A rendere eclatante l’esperimento, peraltro partito per gioco, è stata la semplicità con cui grazie all’intelligenza artificiale gli articoli hanno accumulato visualizzazioni. Fino a qualche giorno prima di andare online con il suo finto blog, Porr non era nemmeno a conoscenza dell’esistenza dei software della famiglia Gpt, e in pochissimo tempo (e con molto meno di mezza giornata di lavoro, ha dichiarato) è passato dal non avere contenuti all’essere virale e in cima alle classifiche, con decine di migliaia di visualizzazioni. Solo uno sparuto numero di lettori ha commentato per protestare, ritenendo il contenuto del post “poco autentico”, ma quei commenti sono stati penalizzati dai voti della community. Allo stesso tempo, il blog ha raccolto un buon numero di iscrizioni.

Prima ancora delle questioni strettamente tecniche, l’accaduto ha subito sollevato alcune perplessità di carattere etico: che cosa accadrebbe se quello strumento fosse usato con intenzioni deplorevoli? Vale davvero la pena, una volta terminata la fase di sviluppo, di rilasciare pubblicamente il software Gpt-3, che al momento pare essere il più avanzato al mondo del suo genere? Il primo a porsi queste domande è stato lo stesso Porr, che prima in modo criptico e poi in modo esplicito ha raccontato quali strategie ha adottato per far guadagnare click ai suoi contenuti.

L’altro grande interrogativo, che ormai è un evergreen dei sistemi automatizzati di scrittura, lo ha riproposto il Mit di Boston: siamo ormai al punto in cui un sistema computerizzato e intelligente di scrittura può eguagliare o superare nelle performance i competitor umani? O, detto altrimenti, si potrebbero generare con questi sistemi grandi quantità di testi di disinformazione capaci di ingannare almeno una parte dei lettori? Difficile dare una risposta, ma i risultati ottenuti con un software addestrato solo da metà luglio e usato da un neofita per pochi giorni lasciano intendere che si stiano facendo passi da gigante.

Tecnologia e astuzia per la viralità

A conti fatti, sono almeno un paio gli ingredienti (altrettanto importanti) che si sono rivelati vincenti. Anzitutto l’innegabile valore tecnologico del software di intelligenza artificiale, che dopo aver digerito miliardi di strutture sintattiche e di collegamenti logici tra parole è in grado di formulare in piena autonomia intere frasi, o addirittura un testo strutturato in paragrafi a partire semplicemente da un titolo e un sottotitolo. Il modo di ragionare dell’algoritmo è piuttosto diverso da quello umano, perché è in grado di trovare pattern e regolarità nell’uso della lingua, individuando quali parole è meglio accostare tra loro sia in termini di significato sia di struttura del periodo.

Nonostante il testo che ne risulta sia piuttosto povero a livello di contenuti e consista di una serie di frasi un po’ vuote di significato ma piene di parole chiave, nel complesso gli articoli sono leggibili, sensati e scorrevoli, e non così diversi da molti altri testi che si trovano online, scritti da umani e con un occhio attento alla Search Engine Optimization (Seo).

A partire da questa piattaforma potentissima, Porr ci ha poi messo del suo. Da un lato ha selezionato molto accuratamente gli argomenti da affrontare, in modo che fossero sia capaci di interessare un pubblico vasto sia abbastanza generici (e incentrati sulla fuffa) da scongiurare problemi legati a strafalcioni, mancanza di approfondimento e falsità contenutistiche. Dall’altro ha fatto una rilettura dei testi prima di metterli online, eliminando sia gli errori lessicali sia tutte quelle frasi che avrebbero più probabilmente fatto sospettare i lettori dell’originalità del testo. Modifiche comunque molto piccole, e in alcuni casi addirittura nulle. Va detto che nel caso specifico i testi sono fake nel senso che non sono autentici, ma a livello di contenuti non contengono bufale. E non è un caso che il risultato migliore sia stato ottenuto con un classico articolo acchiappa-click, ossia Ti senti improduttivo? Forse dovresti smetterla di pensare troppo, né di taglio davvero giornalistico né particolarmente tecnico.

Infine, una piccola nota dal dietro le quinte: nonostante Porr abbia tutte le qualifiche per avere accesso formalmente alla versione beta del software – e nonostante la stia usando da settimane – finora l’uso del software gli è stato ufficialmente negato. Qualcuno ipotizza che l’esperimento non abbia fatto piacere ai gestori del progetto.

FONTE